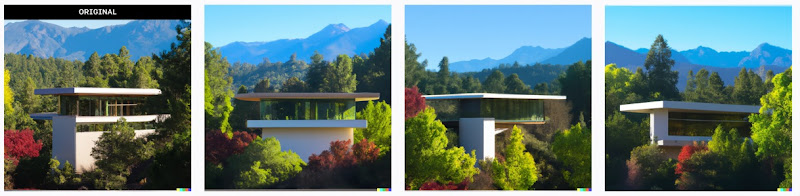

Her vil jeg imidlertid dele et konkret forsøk, en form for skisseøvelse med Open AIs Dall-E. Her bruker jeg den versjonen som gir bilder med relativt lav oppløsning, men jeg tror likevel dette gir et visst inntrykk av hvordan en kan jobbe med dette i fremtiden.

Jeg begynner med denne teksten: "A small modernist cottage in the style of Frank Lloyd Wright placed in the pine woods with mountains in the background."

Resultatet ble i første omgang disse fire bildene:

Et mer reelt scenario vil innebære at en også gir maskinen tekstkommandoer som bidrar til å raffinere bildene i den retningen oppdragsgiveren ønsker. Det er nok i denne sammenhengen at en fagperson vil kunne spille en betydelig rolle også i fremtiden. Her ville jeg kanskje lagt til et ønske om en utvendig trapp opp til takterrassen.

Det som kan fremstå som ansatsen til en takterrasse forsvinner imidlertid på den neste versjonen som maskinen gir meg:

Neste versjon:

Og jeg avslutter med denne versjonen:

:Det er åpenbare svakheter i hvordan maskinen tolker teksten, men det er likevel grunn til å spørre segVil dette kunne ha betydning for arkitekters rolle i fremtiden. Åpenbart, slik jeg ser det, ikke minst gitt at denne teknologien fremdeles er helt i begynnelsen.

Bildene genereres med teknikker som ikke baserer seg på 3D-modeller. Det er dermed ikke en direkte link til det som kan danne grunnlag for tegninger. Jeg tror imidlertid denne delen absolutt er løsbart, jmf denne saken på Archdaily som allerede er noen år gammel. Her vises det også til et spennende prosjekt ved Harward.

Den videre utviklingen betyr nok ikke at profesjonelle blir uten oppgaver, men måten en kommuniserer med kunder vil utfordres.

Legg inn en kommentar